はじめに

※執筆後に追記

ローカル環境で動かす意味はなんですか?ローカル環境で小説生成AIを行うのは多くのデメリットが存在します。VRAM 16GB以上のグラフィックボードを持ってないと、まともに使うことは難しい。

ローカルLLMは、創作の自由度とプライバシーを最大化したい作家や創作者にとって非常に強力なツールですが、環境構築やハード要件は注意すべき点です。特に本格的に使うなら、13B〜クラスのモデルを安定して動かせるマシンが必要。自分はVRAM6Gなので7Bすら苦しい。

同様の人は大人しくクラウドLLMを使いましょう。また、性能を満たしてる人でも一度こちらからさらっと内容を確認してみよう。

苦労して環境構築したのに、後から後悔するようなことはしたくないでしょう。

Modelの詳しい特徴や導入については説明しておりませんので、考慮の上で記事を読み進めるか判断してください。

なんでローカルで動かすの?

ChatGPTなどに比べて性能に劣るローカル環境で動かす意味と言えばロマンしかないでしょ。マロン美味しいよね

一般的な用途ならChatGPTとかのクラウドなLLMサービスの方が良いよ

小説AI:無料・有料比較(クラウド)

| ツール名 | 無料でできること | 有料版との違い | クリエイティブ業界での活用事例 |

|---|---|---|---|

| AIのべりすと | 非ログインでも利用可(制限あり) | 無制限高速化。高性能AIモデル使用可 | ライトノベル企画、脚本 |

| Sudowrite | 初回無料トライアル(少量の文字数制限) | 文字数増加、キャラ・構成支援機能解放 | 出版前のプロット試作、ラノベ作家の執筆補助 |

| NovelAI | 非ログインでもデモ利用可(保存不可) | イラスト付き生成、キャラ設定保存可能 | ビジュアルノベル企画、脚本の初期案作成 |

| Jasper | 短いプロンプトで簡易生成体験可 | ブランディング機能、長文構成機能 | ライトノベルプロット制作、海外翻訳の校正支援 |

| ChatGPT | 無料で物語生成可能(DALL·Eなどと連携も可) | GPT-4では構成力・記憶力が向上 | 雑誌連載小説の構成下書き、コピーライター補助 |

| DeepStory | 制限付きでストーリー生成可能 | 詳細な構成、キャラ設計支援が強化 | 映像脚本の草案制作、配信ドラマの初期プロット |

それでも挑戦したい人はどうぞ

本体ダウンロード

公式サイトに移動して[text-generation-webui-main.zip]をダウンロード。解凍しておきましょう

Condaをインストール

Conda 環境の為にインストールする選択肢。自分はWindows環境で商用利用制限のないMambaforgeを選択

- Anaconda

- Miniconda

- Miniforge

- Mambaforge

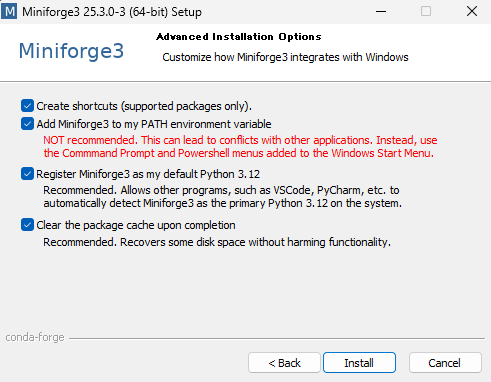

Mambaforge をインストール

Windows用:https://github.com/conda-forge/miniforge#install

- ショートカットを作成しますか?

- miniforge3 を PATH 環境変数に追加します。

推奨されません。他のアプリケーションとの競合が発生する可能性があります。代わりに、Windows のスタートメニューに追加されたコマンドプロンプトと PowerShell メニューを使用してください。 - miniforge3をデフォルトのPython 3.12として登録する

推奨。vscode、pycharmなどの他のプログラムがシステム上の主要なpython 3.12としてminiforge3を自動的に検出できるようにします。 - 完了時にパッケージキャッシュをクリアする

推奨、機能性を損なうことなくディスク容量を回復します

自分は全てにチェックを入れました。2番のPATH環境変数の追加が一番の肝になります。

チェックを入れてよいケース

-

他に Conda 系ツール(Anaconda、Miniconda など)をインストールしていない

-

Mambaforge をメインの Conda 環境として使う予定

-

コマンドプロンプトや PowerShell で

condaやmambaを直接使いたい -

text-generation-webui のセットアップをスムーズに進めたい

チェックを入れると何が起きるか?

-

環境変数

PATHに Mambaforge のbinやScriptsディレクトリが追加される -

これにより、どのコマンドプロンプトからでも

condaやmambaが使えるようになります -

他の Conda 環境(Anaconda など)と同居していると競合することがあるため「非推奨」とされています

結論

condaは他のアプリでは使う予定がないのなら、全てにチェックいれましょう。

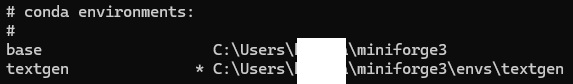

仮想環境を作成。有効化

インストールしたMambaforge(miniforge3)の機能を使っていきます。

- 仮想環境を作成し、有効化

conda create -n textgen python=3.10 -y conda activate textgen※Python 3.10 が安定

正しく構築できているか確認

- 現在のPythonバージョン確認

python --versionPython 3.10.○○が出力されていればOK

違う出力結果なら、下記コードにて構築を確認python --version -

conda --version自分はconda 24.1.2と出力

- 完了したか実体を確認

where python正しく仮想環境が有効なら、このような行が出ます

C:\Users\○○○\miniforge3\envs\textgen\python.exe

ここまでの最終チェック

| チェック項目 | OKの目安 |

|---|---|

(textgen) がプロンプトに表示されている |

✅ |

where python に envs\textgen\python.exe が含まれている |

✅ |

python --version が 3.10.x |

✅ |

環境構築(後半)

- Miniforge Prompt を起動する

スタートメニューから「Miniforge Prompt」を検索して起動

- 仮想環境を有効化(必ず最初に行う)

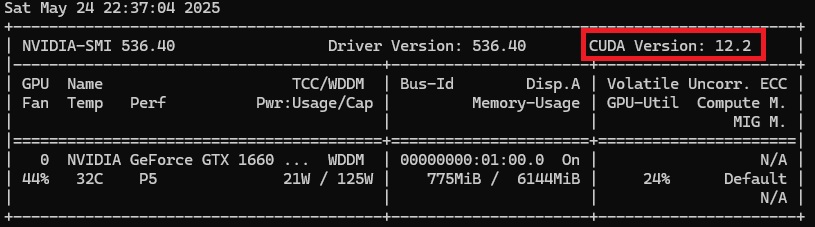

conda activate textgen - 自分のGPUが対応しているCUDAを確認

nvidia-smi - CUDA 12.1 用ホイールでインストール

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121※cu122は最新のため不具合エラーが出たので注意。2025/05/24時点ではCUDA 12.2版のビルドがまだ完全に揃っていない可能性が高い

- 依存パッケージのインストール場所を確認

C:\Users\名前\Desktop\text-generation-webui\requirements\full

※インストール場所の完全パスは[Ctrl+c]でコピーしておいてください

※インストール場所の完全パスは[Ctrl+c]でコピーしておいてください - ディレクトリへ移動するため、Ctrl+vで貼り付け

cd C:\Users\名前\Desktop\text-generation-webui\requirements\full※

C:\Users\名前\Desktop\ は環境によって変わりますので必ず自分の環境のパスに変更してください - 依存パッケージのインストール

pip install -r requirements.txt※

requirements.txtがあるフォルダで実行 (text-generation-webui-main\requirements\full ) - 元の階層へ移動(\text-generation-webui)

cd ../.. - web UIを起動

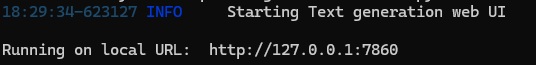

python server.py

起動確認

ブラウザで http://localhost:7860 にアクセス

起動の度に必要な作業

-

conda activate textgen cd C:\Users\***\Desktop\text-generation-webui python server.py2行目のディレクトリ移動は自分の環境にあわせてください

※面倒な場合は1発で起動できるバッチファイルを作成しましょう

日本語LLMのダウンロード

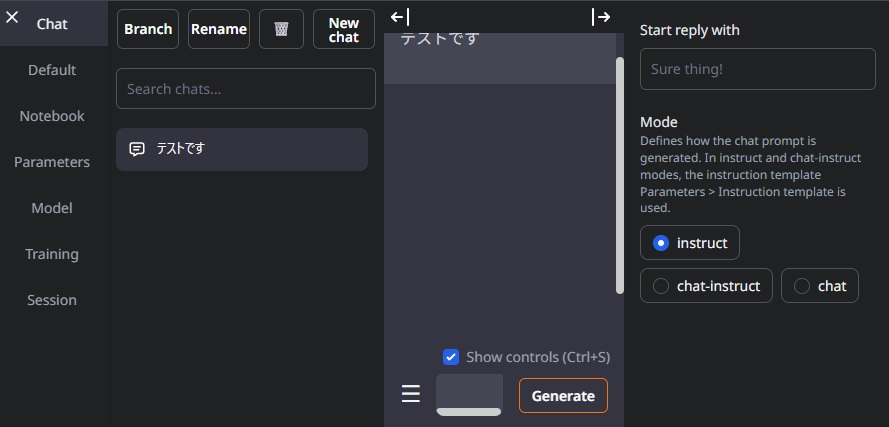

使用方法(モデル導入)

-

Text Generation WebUIを起動し、ブラウザで

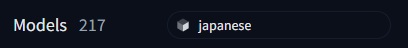

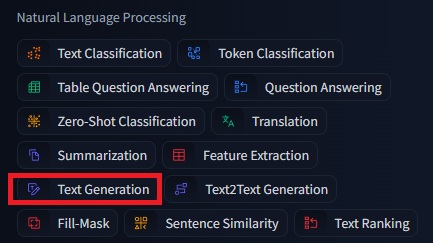

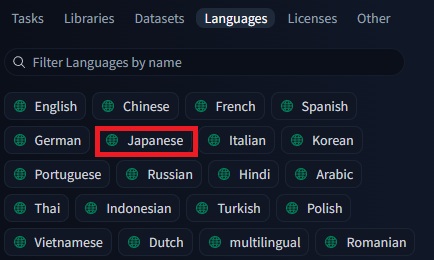

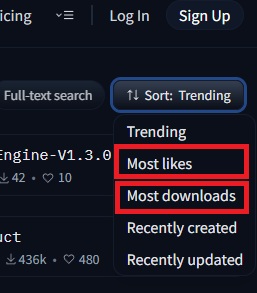

http://localhost:7860にアクセスします。 - Hugging Face で日本語LLMを探す。taskから[Text Generation]。Languagesから[Japanese]。Sortを選択。3を参照

-

- ※絞り切れない場合は、追加でモデル検索フォームに[jp]や[ japanese]など、modelに語句が含まれるものを探してもいいかもしれない。

-

Text Generation WebUIで「Model」タブを開き、「Download custom model or LoRA」欄に、使用したいモデルのリポジトリ名(例:stabilityai/japanese-stablelm-base-alpha-7b)を入力します。

-

「Download」ボタンをクリックしてモデルをダウンロードします。

-

ダウンロード完了後、モデル一覧を更新し、目的のモデルを選択します。

-

適切なローダー(例:AutoGPTQ、llama.cppなど)を選択し、「Load」ボタンをクリックしてモデルを読み込みます。

- モデルによっては依存パッケージの追加インストールが必要

//stabilityai/japanese-stablelm-base-alpha-7bの場合 pip install sentencepiece einops※

requirements.txtがあるフォルダで実行 (text-generation-webui-main\requirements\full )

終わりに

浪漫ですな。画像生成に比べると面倒に感じた。(必要な性能とModelSize的に)

数年後には、十分な性能の日本語LLMも出てくるんだろう。それまではクラウドでいいなと感じました。

※コメントポリシーはこちらから。